«Embrassez qui vous voulez!» Quand l’IA générative incite à piétiner les droits fondamentaux

L’essor de l’IA générative aboutit à certains usages menaçant les droits des personnes et questionnant le rapport au réel. Exemple avec le phénomène de «l’AI Kissing».

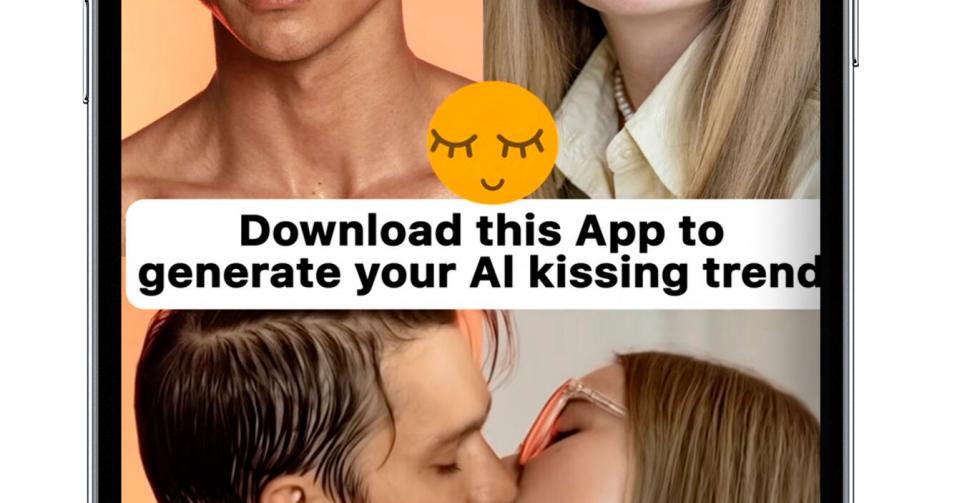

«Embrassez qui vous voulez –virtuellement! Téléchargez l’application, chargez des photos et laissez la magie opérer.» Sous le slogan (originellement en anglais) de cette publicité, une fille et un homme sortent effectivement de leur cadre figé pour produire une courte vidéo d’une étreinte passionnée aussi vraie que nature. Ces derniers mois, de nombreuses applis d’édition ou de retouche photo plus ou moins populaires construisent leur offensive marketing sur les réseaux sociaux à partir de la fonctionnalité «AI Kiss», ou «baiser IA». La plupart du temps, elles incitent leur (jeune) public cible à la tester avec la photo d’un(e) proche qui, bien souvent, n’a jamais marqué son accord pour cela. Dans le meilleur des cas, les apps concernées, recourant à l’IA générative, évoquent dans leurs conditions générales la nécessité d’un «consentement», qui ne sera probablement jamais respecté.

Après la problématique des deepnudes (les déshabillages numériques) dont la création ou la divulgation est pénalement répréhensible en Belgique, le phénomène de «l’AI Kissing» navigue dans un entre-deux qui tend à le banaliser. Certes, il ne s’agit pas ici de dénuder physiquement une personne, mais cette manipulation pose elle aussi bien des questions en matière de consentement, de droit à l’image, de dignité des personnes, de protection de la vie privée et même de rapport aux autres. L’émergence de l’IA générative ouvre un champ des possibles facilitant, aussi, des expressions au mieux futiles, au pire malveillantes, s’inquiètent certains éthiciens. Après les deepnudes ciblant particulièrement les stars et personnalités médiatiques féminines, tout un chacun peut facilement devenir un pantin de l’IA à son insu, en quelques clics à peine.

Quelles conséquences judiciaires?

Sur des blogs ou les réseaux sociaux, certains créateurs de contenu présentent les baisers générés par l’IA comme une fonctionnalité «fun» ou «romantique». Or, la diffusion de tels contenus peut avoir des conséquences pénales. Non pas au regard de l’infraction de voyeurisme, à laquelle se rattache le phénomène des deepnudes, mais bien de l’infraction de diffusion non consentie de contenus à caractère sexuel, punie d’un emprisonnement de six mois à cinq ans. Celle-ci «consiste à montrer, rendre accessible ou diffuser du contenu visuel ou audio d’une personne dénudée ou d’une personne qui se livre à une activité sexuelle explicite sans son accord ou à son insu, même si cette personne a consenti à leur réalisation, commentent les avocats François Dessy et Lucas Pinelli. L’activité sexuelle explicite n’a pas été définie par la loi. Dans cette mesure, il convient d’entendre tout acte dont le caractère sexuel est avéré en se référant à la figure de la personne raisonnable. Dans ce contexte, en fonction de l’utilisation concrète des applications d’IA permettant à leurs utilisateurs d’embrasser « n’importe qui », il pourrait être argué que cela entre dans le champ du critère de l’activité sexuelle explicite.» Ce sera toutefois soumis à une appréciation de la cour.

«Le droit à l’image repose sur le principe de reconnaissabilité. Dès que cette condition est remplie, une personne peut s’en plaindre.»

Bernard Mouffe

Avocat au barreau de Bruxelles et professeur à l’UCLouvain et l’UNamur.

Au civil, le recours à de tels générateurs de vidéos porte également potentiellement atteinte au droit à l’image. «Celui-ci repose sur le principe de reconnaissabilité, expose Bernard Mouffe, avocat au barreau de Bruxelles et professeur à l’UCLouvain et l’UNamur. Dès que cette condition est remplie, une personne peut s’en plaindre, a fortiori s’il y a usurpation d’identité, c’est-à-dire à partir du moment où l’on utilise sciemment son image pour lui prêter une situation qui n’est pas voulue.» A moins que la personne visée ait marqué son consentement exprès, la création d’une vidéo de baiser en fait partie.

Dans ce cas de figure, la violation au droit à l’image commence dès l’instant où un internaute sauvegarde l’image d’un proche pour la transmettre à une application. Bien souvent, la personne concernée n’en sera toutefois jamais informée. Si elle en prend connaissance, «il faut déterminer l’ampleur du préjudice causé, nuance l’avocat. Il est rare d’apporter la preuve que le dédommagement pour le droit à l’image vaille plus que l’euro symbolique.» En revanche, les conséquences d’une diffusion potentiellement plus large ne sont pas toujours anodines. Ainsi, il est arrivé qu’un tribunal réclame autant de fois l’euro symbolique qu’il y a eu de duplications à celui qui se rend coupable de la première atteinte au droit à l’image. Il reviendra alors à ce dernier de se retourner contre les innombrables autres personnes qui ont reproduit le contenu concerné.

Il existe toutefois quelques exceptions. «L’une d’elles est liée au contexte, poursuit Bernard Mouffe. On a toujours considéré qu’il n’y avait pas d’atteinte au droit à l’image dès que celle de quelqu’un, fût-il reconnaissable, est utilisée dans un contexte tel que personne ne peut concevoir qu’il s’agit d’une image réelle.» Le pape en doudoune, un baiser entre Donald Trump et sa rivale démocrate Kamala Harris, entre Emmanuel Macron et Marine Le Pen… De telles photos ont circulé sur le Web ces derniers mois. Plus récemment, les détournements ont pris un nouvel envol avec le lancement gratuit, le 9 décembre dernier, de Grok-2, une IA disponible sur X. Celle-ci permet de générer des images ultraréalistes à partir d’une simple instruction, un «prompt», sans les balises éthiques que fixent des concurrents tels que Midjourney ou ChatGPT. Avec une telle ouverture, toute la difficulté sera de juger si le cliché montrant deux personnes bien réelles est plausible ou non.

Selon Bernard Mouffe, il semble en revanche compliqué de poursuivre les développeurs des applications concernées sur cette base. Ceux-ci pourront objecter qu’ils ne sont pas responsables de l’utilisation qui en est faite. «Il faudrait alors également poursuivre tous les fabricants de caméras cachées, puisque leur dimensionnement vise clairement à violer la vie privée des gens.»

Lire aussi | Grok 2: l’IA de Musk qui effraie…

Que disent les règlements européens?

Entré en application en 2018, le Règlement général sur la protection des données (RGPD) définit les droits fondamentaux des citoyens européens à l’ère numérique. Le texte prévoit une exception pour le traitement de données utilisées dans un cadre strictement personnel et domestique. «Si quelqu’un télécharge la photo d’un proche et l’utilise dans une application pour voir ce que cela donne, sans diffuser le contenu, il sera compliqué de s’y opposer sur la base du RGPD, décode Aurélie Waeterinckx, porte-parole de l’Autorité belge de protection des données (APD). A l’inverse, on sort de ce cadre dès l’instant où un tel contenu est partagé sur les réseaux sociaux; l’auteur devient alors responsable du traitement, avec toutes les obligations qui s’y réfèrent, dont celle du consentement.» Elle rappelle en outre un critère important du RGPD, trop souvent banalisé: «Ce n’est pas parce qu’une photo est disponible sur Internet ou un réseau social que vous pouvez la réutiliser. Le fait que vous postiez une image de vacances sur Facebook à l’attention de vos proches et de vos amis n’autorise personne à la réutiliser à une autre fin sans votre accord.»

Du côté des applications concernées, certaines précisent qu’elles ne conservent ni les images qui y sont chargées ni celles générées. «D’abord, il faut vérifier si c’est vrai, énumère Aurélie Waeterinckx. Si elles hébergent ces photos ne serait-ce que cinq minutes sur un cloud potentiellement piratable, cette assertion est fausse. Ensuite, le fait qu’elles soient conformes sur un point ne signifie pas qu’elles le soient sur les autres. Ces applications ont besoin d’un fondement juridique pour traiter les données, comme par exemple le consentement. Or, une clause de non-responsabilité ne suffit pas à cet égard.» Même si elle est développée ailleurs, toute application traitant des données d’Européens doit, en théorie, se conformer au RGPD.

«Il faut s’inquiéter de la bulle dans laquelle certains sont tentés de s’enfermer, plutôt que d’affronter le réel.»

Louis de Diesbach

Ethicien de la technique.

Qu’en est-il dans la pratique? «Il y a une capacité d’action dans les pays dont la législation de protection des données est reconnue par l’UE, ajoute la porte-parole de l’APD. C’est vrai notamment aux Etats-Unis (dans certains cas), en Suisse ou en Corée du Sud. Il est vrai, néanmoins, qu’il sera plus compliqué d’agir dans des pays qui ne veulent pas coopérer.» Comme le précise l’APD, les violations du RGPD peuvent faire l’objet d’amendes administratives s’élevant jusqu’à 20 millions d’euros ou, dans le cas d’une entreprise, jusqu’à 4% du chiffre d’affaires mondial.

Entré en vigueur en février 2024, le Digital Services Act (DSA) vise, entre autres, à mieux lutter contre la diffusion de contenus illégaux en ligne. Mais ses règles concernent essentiellement les places de marché en ligne, les réseaux sociaux, les boutiques d’applications et les plateformes de voyage et d’hébergement en ligne. En mars, la Commission avait envoyé des demandes d’informations sur les risques liés à l’IA générative à six grandes plateformes (Facebook, Instagram, Snapchat, TikTok, YouTube et X) et à deux moteurs de recherche (Google Search et Bing). En cas de présomption de violation des règles du DSA, la Commission peut entamer des procédures à leur encontre.

Enfin, l’AI Act, en application depuis août dernier, prévoit un ensemble de règles pour une intelligence artificielle «digne de confiance» et préservant les «droits fondamentaux» des personnes. Si un passage concerne bien les «hypertrucages» (deepfakes), celui-ci se limite au fait que leurs auteurs doivent «déclarer de manière claire et reconnaissable que le contenu a été créé ou manipulé par une IA».

Quel rapport au réel?

Au-delà des aspects légaux, la création de contenus artificiels pose des questions éthiques. «Les jeunes ont conscience des principes de réalité, souligne Nathalie Grandjean, docteure en philosophie, chargée de cours invitée à l’UCLouvain et autrice du livre Le Visage capturé (Presses universitaires de Louvain, 2022). Ceci étant, les intelligences artificielles leur permettent de produire de nouvelles représentations du réel. La difficulté, c’est qu’on n’en maîtrise pas la grammaire. Les IA générant des baisers incitent leurs utilisateurs à vivre par procuration ce qui pourrait leur arriver avec untel, mais dans une version idéalisée et dénuée de toutes les répercussions possibles. L’intelligence artificielle n’est pas nécessairement une menteuse, mais c’est à tout le moins une faussaire.»

Les technologies numériques, rappelle-t-elle encore, offrent une utilité particulièrement malléable à leurs usagers. «Même si vous pouvez aussi l’utiliser à mauvais escient, un marteau sert a priori à planter des clous. Les briques technologiques du numérique, elles, sont totipotentes. On ne sait jamais à partir de quel moment et à quel point elles peuvent servir d’autres intentions.» L’IA générative donne précisément accès à d’innombrables chemins, y compris à celui d’un rejet du réel et de ses inévitables limites. «Pourquoi, dans certains cas, le monde ne suffit-il pas?, questionne l’éthicien de la technique Louis de Diesbach. C’est souvent parce qu’il y a un inconfort avec la vulnérabilité que le réel nous impose, alors que l’être humain, lui, aimerait avoir le monde à portée de main. Cette vulnérabilité nous rappelle que non, tout n’est pas possible ni accessible.»

L’IA générative peut ainsi ouvrir une échappatoire relevant du fantasme ou de l’idéalisé. Au point d’enclencher une spirale de rejet du réel? «Pas vraiment, rectifie l’auteur du livre Bonjour ChatGPT (Mardaga, 2024). Cela fait déjà plus de quinze ans que les gens passent de plus en plus de temps sur leurs écrans. L’IA générative ne fait qu’accélérer une spirale déjà à l’œuvre. Selon moi, il faut s’inquiéter de la bulle dans laquelle certaines personnes sont tentées de s’enfermer, plutôt que d’affronter le réel.»

«Avec les technologies, nous perdons la main sur les questions d’autonomie, d’intégrité et de dignité du corps.»

Nathalie Grandjean

Docteure en philosophie et chargée de cours invitée à l’UCLouvain.

Quelles balises fixer?

Comme le souligne Nathalie Grandjean, l’addition de technologies numériques exploitant le corps sous toutes ces facettes (reconnaissance faciale, biométrie, etc.) repose sur un consentement qui n’est que superficiel. «Le RGPD est une régulation juridique et non éthique, relève-t-elle. Du fait de ces technologies, nous perdons la main sur les questions d’autonomie, d’intégrité et de dignité du corps.» Au-delà de la responsabilisation des individus, l’essor de l’IA générative imposerait de définir sans tarder des balises éthiques collectives. Une mission d’autant plus délicate que l’IA émane en bonne partie des Etats-Unis, dont l’éthique très libérale est centrée sur les responsabilités individuelles, souligne l’experte.

Et si l’Europe a la capacité de définir ses propres balises, Nathalie Grandjean s’interroge sur la faisabilité. «Qui participera à la discussion? Comment décidera-t-on des règles à adopter? On le voit, les Etats européens appauvrissent de plus en plus les corps intermédiaires tels que les écoles, les asbl, les fondations… Soit autant d’acteurs en mesure de diffuser les informations en apportant un regard critique.» Afin d’inclure une véritable dimension collective, et donc participative, le chantier de l’éthique d’IA ne pourra se résumer à une compilation monolithique des remarques d’un cercle d’experts dans un unique domaine.

La grief tech, entre intérêt et dérives

Dans l’épisode «Be Right Back» de la série d’anticipation Black Mirror, une veuve découvre avec effroi les répercussions d’une technologie permettant d’échanger avec un alter ego de son compagnon décédé. Depuis lors, l’IA générative a ouvert bien des portes en ce sens. Des applications grand public proposent d’animer un souvenir avec un proche à partir d’une vieille photo. D’autres peuvent imiter la voix d’un défunt à partir d’un bref enregistrement. Pour l’éthicien de la technique Louis de Diesbach, ces grief tech, comme on les appelle, questionnent la dignité des défunts. «Je ne serais pas surpris que des personnes, dans quelques années, mentionnent dans leur testament le souhait de ne pas être réanimé sous la forme de deathbot.»

L’usage de telles technologies peut-il freiner ou faciliter le processus de deuil? La réponse à cette question est, elle, plus nuancée. Professeure à l’Institut de recherche en sciences psychologiques de l’UCLouvain, Emmanuelle Zech invalide d’emblée la «théorie des stades», selon laquelle le deuil passerait par diverses étapes communes à tous les individus. «Tous ces diktats viennent ajouter des contraintes à la personne endeuillée, alors que chacun traverse cette épreuve à sa manière.» Selon les cas, le recours à l’une ou l’autre grief tech pourrait constituer un support utile dans le cadre d’un suivi thérapeutique, suggère-t-elle. «Ce serait quelque chose à construire, par exemple dans le cadre d’un outil appelé « la chaise vide« . Celle-ci représente le défunt à qui la personne endeuillée souhaiterait communiquer, que ce soit pour exprimer des regrets, de la colère… Je pourrais tout à fait imaginer une expérience plus immersive grâce aux technologies. Le vécu émotionnel en séance est en effet un bon indicateur du processus thérapeutique.»

Vous avez repéré une erreur ou disposez de plus d’infos? Signalez-le ici