L’essentiel

· De plus en plus de femmes sont victimes de deepnudes, des images ou vidéos pornographiques créées à partir d’une simple photo de leur visage, avec l’aide de l’intelligence artificielle.

· En 2023, 143 868 nouvelles vidéos deepnudes ont été téléchargées sur les 40 sites de deepfake porn les plus visités.

· Les femmes en sont les principales victimes.

· Les deepnudes peuvent causer des dommages mentaux graves aux victimes, tels que des troubles anxieux, des dépressions et des pensées suicidaires.

· Les deepnudes sont utilisés comme modèle de revenus, avec certaines personnes quittant leur emploi pour se consacrer à la création de deepfakes pornographiques. Des sociétés de cartes de crédit et de paiement facilitent involontairement ce business.

· L’un des principaux enjeux est de sensibiliser les jeunes générations.

De plus en plus souvent, des femmes apparaissent contre leur gré dans des images ou des vidéos pornographiques. À partir d’une simple photo du visage d’une personne, les auteurs créent de faux films ou des deep fake à l’aide de l’intelligence artificielle. Ces abus se développent particulièrement rapidement.

En 2021, la journaliste et présentatrice néerlandaise Welmoed Sijtsma, 33 ans, reçoit un message via Instagram de la part d’un inconnu. Une fausse vidéo porno d’elle aurait circulé sur l’internet. «Au début, je n’osais même pas la regarder, raconte-t-elle un an plus tard dans le documentaire Welmoed en de sexfakes. Une fois que je l’ai fait, je n’ai pas non plus osé la montrer à quelqu’un d’autre parce que, c’est fou, même si ce n’était pas moi, j’étais très gênée.»

Dans ce documentaire, la trentenaire part à la recherche de l’auteur et du diffuseur de la fausse vidéo. «Une vidéo dans laquelle mon identité a été volée, errant sur internet et apparaissant dans des groupes WhatsApp de connaissances. Mais surtout, une vidéo qui m’a entraînée dans un monde dont je connaissais à peine l’existence. (…) Bien que je sache que mon travail attire l’attention de manière positive et négative, je n’avais jamais imaginé qu’un deepfake de moi puisse être réalisé. Et pas n’importe lequel: un deepfake porno. Je joue donc dans un film que je n’ai jamais réalisé. Ma tête est collée sur corps d’une actrice dans une vidéo à caractère sexuel. Pendant près de dix minutes, j’ai eu l’impression de me regarder.»

Du porno hyperréaliste

Les deepfakes sont des images créées entièrement ou partiellement à l’aide de l’intelligence artificielle (IA). Si ces images sont sexuellement explicites, elles sont appelées «deepnudes». «Il existe trois façons d’en créer, explique la professeure de droit Catherine Van de Heyning (université d’Anvers), spécialisée dans la cybercriminalité. Le visage d’une personne nue peut être remplacé par un autre visage. Cette technique s’appelle le « face swapping » et les résultats sont souvent hyperréalistes. Il existe également la technique du déshabillage, dans laquelle l’intelligence artificielle prédit l’apparence d’une personne nue. L’utilisateur télécharge alors la photo d’une femme en bikini, par exemple, et la technologie le lui enlève. Enfin, il y a le porno IA : une personne nue entièrement générée par l’intelligence artificielle, ce qui en fait, en un sens, la forme la plus innocente. Le seul problème est que cette technologie est entraînée à partir d’images de personnes existantes, et vous pouvez entrer des messages comme : « une femme nue qui ressemble à Taylor Swift ».»

En 2023, 143.868 nouvelles vidéos deepnudes ont été téléchargées sur les 40 sites de deepfake porn les plus visités.

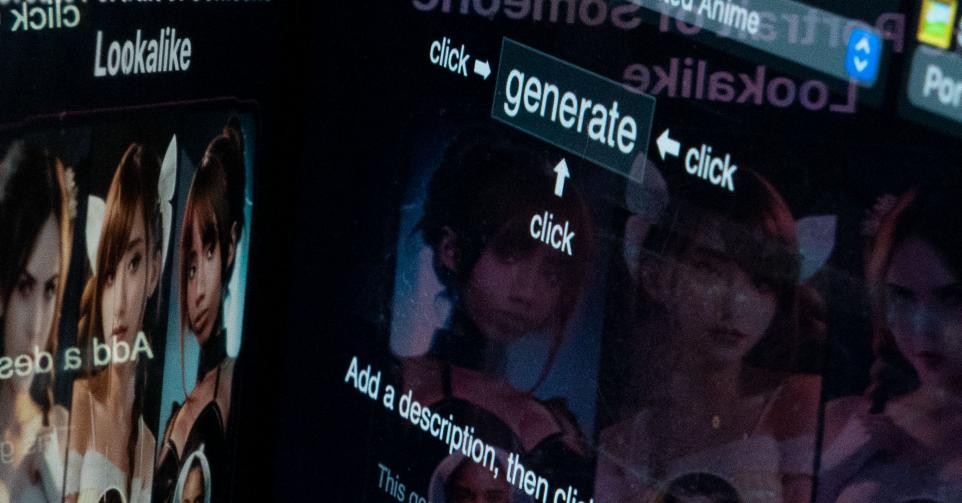

Cette technologie est utilisée depuis longtemps dans des studios de cinéma renommés mais, avec la popularité croissante de l’IA générative, elle a trouvé son chemin vers le grand public. Les principaux outils permettant de générer des images grâce à l’intelligence artificielle sont dotés de protections intégrées qui empêchent la création de deepnudes, mais ils ne sont pas infaillibles. D’autres générateurs d’images n’offrent pas de telles garanties. Ce qui nécessitait autrefois du talent et des compétences peut désormais être obtenu en quelques clics.

Les deepfakes destinés à faire des blagues ou de la propagande sont bien connus. Mais, aujourd’hui, la technologie est principalement utilisée pour générer du matériel à caractère sexuel. Une vidéo pornographique de deepfake a été signalée pour la première fois en 2016. Selon une étude menée par l’analyste américaine Genevieve Oh, en 2023, 143.868 nouvelles vidéos de deepnude ont été téléchargées sur les 40 sites de deepfake porno les plus visités, soit plus que toutes les années précédentes réunies. L’augmentation est exponentielle. Le deepnude devient l’une des formes d’abus qui se développent le plus rapidement.

Quasi que des femmes dans le «fake porno»

Il y a cinq ans, une analyse a montré que 96 % de toutes les vidéos deepfake étaient sexuellement explicites et que 99 % de ces images pornographiques représentaient des femmes. Dans la plupart des cas, elles n’ont jamais donné leur consentement. Un rapport de 2023 indique que, depuis, 98 % de tous les deepfakes sont sexuellement explicites.

Etonnamment, les deepnudes d’hommes ne sont pas seulement rares, ils sont aussi de moindre qualité. «Les algorithmes sont entraînés spécifiquement sur le corps des femmes, explique Catherine Van de Heyning. Cela révèle une inégalité plus profonde entre les sexes, un manque de respect pour les femmes et la violence sexuelle dans la société. La technologie ne fait qu’encourager l’objectivation des femmes. De plus, il ne s’agit pas toujours de satisfaire un fantasme. Une fausse vidéo porno peut aussi être utilisée pour réduire les femmes au silence.»

Le plus grand site de deepfake porn propose plus de 1.000 vidéos dans lesquelles l’actrice Emma Watson «joue» malgré elle

«Ce n’est pas une coïncidence si cela se produit souvent avec des femmes politiques qui veulent rendre les règles autour des deepfakes plus strictes, comme la députée progressiste américaine Alexandria Ocasio-Cortez. Ou avec des féministes déclarées, comme l’actrice Emma Watson. L’un des sites les plus populaires a utilisé Emma Watson dans son image promotionnelle pendant plus d’un an», raconte Catherine Van de Heyning. Le plus grand site de deepfake porno propose plus de 1.000 vidéos dans lesquelles Emma Watson «joue» malgré elle.

Les deepnudes ne sont pas seulement diffusés sur des sites pornographiques douteux. En janvier, X a dû bloquer le terme de recherche «Taylor Swift» après qu’une fausse image à connotation sexuelle de la pop star américaine soit devenue virale sur la plateforme. L’image a été vue 45 millions de fois, partagée à 24.000 reprises et a reçu des centaines de milliers de likes avant d’être mise hors ligne.

Si des centaines de deepnudes sont réalisés au détriment de femmes célèbres, des inconnues sont également massivement victimes de cette technologie. Trois semaines après le lancement d’une application de deepnude en août de l’année dernière, plus de 600.000 femmes avaient déjà été déshabillées virtuellement grâce à elle. «Beaucoup de victimes ne savent même pas qu’il existe de telles photos d’elles», assure Catherine Van de Heyning.

Gimmick

En début d’année, l’université d’Anvers a mené une étude sur la connaissance et l’utilisation des applications et technologies de deepnudes chez les jeunes Belges âgés de 15 à 25 ans. «41,9 % de ce groupe savent ce qu’est une image de deepnude, explique Catherine Van de Heyning, l’un des principaux auteurs de l’étude. Comme il s’agit d’une auto-déclaration, le chiffre réel est probablement encore plus élevé.»

En outre, six jeunes sur dix connaissant des applications de deepnude avouent avoir déjà essayé de créer un. «C’est inquiétant, estime la chercheuse anversoise. Si les jeunes connaissent l’offre, ils sont plus susceptibles de l’utiliser.» L’étude montre également que les hommes sont nettement plus enclins à créer de telles images. Leurs motivations vont de la vengeance à la volonté d’impressionner leurs amis.

Catherine Van de Heyning constate que les jeunes n’ont pas tous la même attitude à l’égard de l’envoi de vraies ou de fausses images. «Seul un quart des jeunes transmettrait de vraies images de nudité. Il semble donc y avoir un consensus sur le fait qu’une telle chose ne se fait pas. En ce qui concerne les deepnudes, le seuil est plus bas, car ils sont de toute façon considérés comme un gadget. Notre hypothèse est que les jeunes de cette génération sont tellement habitués à appliquer des filtres sur les images que, moralement, ils ne font pas la différence entre mettre un nez de cochon sur le visage d’une personne ou faire un deepnude de quelqu’un. Nous constatons aussi de plus en plus ce phénomène dans les écoles.»

L’année dernière, Child Focus a ouvert pour la première fois un certain nombre de dossiers sur les deepnudes. «L’augmentation du phénomène nous inquiète, déclare Niels Van Paemel, conseiller politique. Grâce à notre service d’assistance téléphonique, nous recevons de plus en plus de questions de la part de jeunes sur des images truquées, qui se sont effectivement retrouvées dans les écoles. C’est le point de basculement que nous redoutions. Les deepnudes sont au carrefour du genre, de la cyberintimidation, de l’exposition (NDLR: diffusion numérique d’images privées sans autorisation dans le but de nuire ou d’humilier la personne représentée), de l’exploitation sexuelle et de la maltraitance des enfants. Tout y est réuni.»

L’Institut pour l’égalité entre les hommes et les femmes, où les victimes adultes peuvent déposer un signalement, en a reçu un premier 2021. En 2023, il y en a eu trois ; cette année, le compteur s’élève provisoirement à six. Selon l’institut, ces chiffres ne sont que la partie émergée de l’iceberg. La plupart des gens ne savent pas encore que les deepnudes sont punissables et qu’ils peuvent contacter l’institut pour obtenir plus d’informations sur les démarches à entreprendre, ou se faire aider pour déposer une plainte auprès de la police.

Fausses images, vraies conséquences

La pornographie deepfake n’est donc pas limitée à des personnes d’un certain milieu, d’une certaine profession ou d’un certain âge. Tout le monde peut en être victime et personne ne peut rien faire pour s’en protéger, puisqu’une seule photo suffit aux auteurs.

Welmoed Sijtsma, la présentatrice télé, avait fini par montrer la vidéo sa famille et ses amis. Son père avait catégoriquement refusé de la regarder, même en sachant qu’il s’agissait d’un faux. «Je ne veux pas que cette image de toi dans cette situation se fixe dans mon cerveau, avait-il justifié. Je pense que si tu la montres à d’autres personnes, elle ne quittera jamais leur esprit.»

Les deepnudes peuvent causer de graves dommages mentaux, entraînant des troubles anxieux, des troubles psychiques, des dépressions, une perte de confiance en soi et même des pensées suicidaires.

«Cela s’explique par la façon dont notre cerveau traite les informations», explique Marthe Goudsmit Samaritter, qui effectue des recherches sur les deepfakes et la vie privée en ligne à l’Institut Max Planck. Une fois que nous avons vu quelque chose, l’image reste sur nos rétines, même si nous nous rendons compte qu’elle est fausse.»

Les images ont beau être fausses, pour les victimes, les conséquences sont réelles. «Les recherches ont montré qu’elles subissent le même type de préjudice que les personnes dont les images de nus authentiques circulent ou qui ont été filmées secrètement», explique Goudsmit Samaritter. Les deepnudes peuvent causer de graves dommages mentaux, entraînant des troubles anxieux, un syndrome de stress post-traumatique, des dépressions, une perte de confiance en soi et même des pensées suicidaires.

«L’un des plus grands problèmes après un abus sexuel par imagerie est l’exclusion sociale, explique Goudsmit Samaritter. Une personne peut se sentir tellement honteuse que cela nuit à ses contacts sociaux. La diffusion d’images de nudité affecte également la manière dont les victimes sont perçues et traitées. L’abus sexuel par l’image prive les victimes d’une grande partie de leur autonomie : elles perdent la capacité d’influencer délibérément et intentionnellement leur propre vie et leurs conditions de vie.»

L’Institut pour l’égalité entre les hommes et les femmes ne constate pas non plus de différence entre les personnes qui signalent la diffusion non consensuelle d’images de nu authentiques ou fausses. Les victimes souhaitent que la diffusion des images cesse le plus rapidement possible et ont souvent peur de l’impact de ces images sur leur réputation.

Même lorsque des deepnudes sont utilisés comme outil d’extorsion, le fait que l’image soit vraie ou fausse ne fait guère de différence pour les victimes. «Les victimes ne veulent tout simplement pas qu’une image d’elles nues circule, même s’il s’agit d’un deepfake», explique Catherine Van de Heyning.

Modèle de revenus

«Lorsque les deepnudes sont conçus pour le plaisir et l’excitation sexuelle, les utilisateurs ne se rendent souvent pas compte qu’ils peuvent être nocifs et même punissables, poursuit Catherine Van de Heyning. Cette (fausse) impression est en outre alimentée par la grande disponibilité d’applications qui permettent non seulement de voir, mais aussi de créer des deepfakes sexualisés. Sur Google, des publicités ont même été diffusées pour de tels outils, de sorte qu’ils se sont retrouvés tout en haut des résultats de recherche. Bien que ces applications violent les conditions d’utilisation de Google, il suffit d’une simple recherche pour les trouver. Tandi que Google bénéficie ainsi de revenus publicitaires supplémentaires.»

Lire aussi | Un Belge sur cent victime de «revenge porn»

Sur les plateformes de médias sociaux de Meta (Facebook et Instagram), des publicités payantes sont également diffusées pour des applications qui encouragent les utilisateurs à faire des fausses images de nu. On peut y lire : «Déshabillez n’importe quelle fille». Au printemps dernier, une application de deepnude a fait de la publicité sur Instagram avec une fausse image nue (censurée car la plateforme élimine les tétons des femmes) de l’actrice Jenna Ortega, avec une photo datant de l’époque où elle avait à peine 16 ans et n’avait donc pas l’âge requis. Google et Meta ont récemment indiqué qu’ils travaillaient sur des moyens de retirer plus rapidement de telles images de leur plateforme ou de les faire apparaître plus bas dans les résultats de recherche. En ce qui concerne l’autorisation des publicités pour les applications, les géants du web restent silencieux.

«Les deepnudes ne sont donc pas des images créées et diffusées exclusivement dans les coins les plus sombres de l’internet. Ces images et vidéos sont tout aussi largement diffusées dans des groupes sur Snapchat, Reddit ou Telegram, énumère Catherine Van de Heyning. Les gens y demandent si quelqu’un a une image de nu d’une femme en particulier, ou proposent de réaliser un nu parfait d’une personne de leur choix contre rémunération.»

Parfois, la production de deepfake porno est si lucrative que les gens quittent leur emploi normal pour s’y consacrer.

Ceux qui proposent leurs services pour générer des deepnudes peuvent donc aussi gagner de belles sommes d’argent. «Le « deepfake porn » et d’autres formes d’abus sexuels par l’image constituent un modèle de revenus, explique Marthe Goudsmit Samaritter. Parfois, c’est tellement lucratif que les gens finissent par quitter leur emploi normal». Certains «créateurs» recrutent même du personnel.

Sur la plupart de ces sites, les utilisateurs peuvent effectuer des recherches simples et parfois générer des images gratuitement. Ce n’est que lorsqu’ils souhaitent bénéficier d’options supplémentaires (telles que l’exportation d’images en haute résolution, des vidéos plus longues, la personnalisation de l’âge ou des caractéristiques corporelles ou des demandes spécifiques) qu’ils doivent acheter des crédits. Le prix varie, d’un à quelques centaines de dollars. Des abonnements sont également vendus, donnant accès à des bibliothèques en ligne contenant des milliers de vidéos. Enfin, les entreprises à l’origine des applications tirent également des revenus de la publicité.

Une étude menée par le journal néerlandais Het Financieele Dagblad montre que les sociétés de cartes de crédit Visa et Mastercard et le service de paiement PayPal sont utilisés par des applications de pornographie deepfake. «Ils facilitent involontairement et indirectement les deepnudes», écrit le quotidien FD. Par ailleurs, Visa et Mastercard gagnent de l’argent sur chaque transaction financière effectuée sur leur réseau et sur chaque paiement effectué avec leur carte.

Pionniers

En Belgique, le fait de réaliser des deepnudes à partir d’une personne existante sans autorisation est punissable. «Quiconque le fait se rend coupable de voyeurisme, explique Catherine Van de Heyning. Le législateur a défini cette loi de telle manière qu’elle ne concerne pas seulement l’observation, mais aussi le fait de faire observer et de réaliser des images. Ce n’est que dans le cas de clichés entièrement générés par l’IA, n’impliquant pas une personne réelle, qu’il n’y a pas de voyeurisme criminel. La Belgique a été pionnière dans ce domaine. Plusieurs autres pays ont petit à petit suivi.»

Au niveau européen, la loi sur l’IA, qui est entrée en vigueur le 1er août dernier, aurait également pu avoir un impact. «Mais à notre grande frustration, elle a considéré les deepfakes comme une technologie présentant un risque limité, rappelle Catherine Van de Heyning. Lorsque la loi sur l’IA a été créée, elle avait à l’esprit des deepfakes à caractère politique, comme la vidéo du CD&V faisant revivre l’ancien premier ministre Jean-Luc Dehaene. Le fait que 98 % des deepfakes soient des deepnudes n’a même pas été pris en compte.»

Selon la chercheuse anversoise, il n’est pas nécessaire d’interdire les deepfakes. «Cette technologie est utilisée de manière responsable dans l’industrie du cinéma et de la mode. Mais une application qui permet à n’importe qui de créer une image de nudité d’à peu près n’importe qui, c’est une autre histoire. C’est là que la loi sur l’IA a complètement raté le coche. Nous pourrions toutefois exiger des applications qu’elles conservent l’adresse IP de leurs utilisateurs afin de pouvoir les retrouver s’ils réalisent une image criminelle. Une mesure plus extrême consisterait à n’autoriser la technologie que pour des applications commerciales et à en faire un produit sous licence, tout comme les outils considérés comme des technologies à haut risque dans la loi sur l’IA.»

En outre, en avril, l’Union européenne a adopté de premières directives pour lutter contre la violence à l’égard des femmes. Ces règles concernent le «cyberflashing», c’est-à-dire l’envoi non consensuel d’images de nudité, manipulées ou non. «Une réglementation à ce niveau peut avoir un impact important sur la lutte contre les images de nus profonds, déclare Catherine Van de Heyning. Elle pourrait créer des conditions équitables au sein de l’UE sur lesquelles les victimes, les organisations d’aide, la police et la justice pourraient s’appuyer vis-à-vis des acteurs en ligne, tels que les médias sociaux, pour retirer les images.»

Pourtant, à l’heure actuelle, il reste difficile de criminaliser les développeurs et les fournisseurs d’applications. Raison pour laquelle Catherine Van de Heyning plaide également en faveur de la responsabilité des entreprises, afin que les sociétés technologiques et les services de paiement cessent de soutenir les applications de deepnudes. «Sous la pression d’une campagne que nous avons menée précédemment, Android et Apple en ont déjà supprimé certaines de leur boutique. Une telle mesure peut avoir un effet positif.»

Changement de culture

En novembre 2023, le tribunal d’Amsterdam a condamné un homme de 39 ans à 180 heures de travaux d’intérêt général avec sursis pour avoir réalisé la vidéo pornographique deep-fake de la présentatrice Welmoed Sijtsma.

Une génération d’enfants grandit en pensant qu’il est normal de faire des deepnudes. Cette normalisation doit cesser.

«Pourtant, la législation ne suffira pas à résoudre le problème de la pornographie de type « deep-fake », prévient Marthe Goudsmit Samaritter. Pour cela, un changement social est nécessaire. Une génération d’enfants grandit en pensant qu’il est normal de faire des deepnudes. Cette normalisation doit cesser.»

Child Focus abonde. «Nous devons parler aux garçons de la masculinité toxique, déclare Niels Van Paemel. Il s’agit d’une tâche sociale dans laquelle chacun a une part de responsabilité. Malheureusement, nous constatons que l’éducation aux médias et la sexualité sont à peine abordées dans l’enseignement.»

Enfin, Marthe Goudsmit Samaritter estime qu’il faut changer d’attitude à l’égard des abus en ligne. «Parce qu’ils ne sont pas physiques, ils sont moins pris au sérieux socialement. Mais les victimes subissent le même type d’expérience. Une violation en ligne peut être tout aussi préjudiciable qu’une violation hors ligne.»