Intelligence artificielle: comment la « computer vision » bouleverse notre quotidien (décryptage)

Les progrès de la « computer vision », une branche de l’intelligence artificielle, bouleversent lentement mais sûrement notre quotidien. Décryptage avec quatre start-up wallonnes présentes au Consumer Electronics Show, le salon mondial de l’innovation technologique.

La prouesse n’a probablement pas alarmé les champions de F1 Lewis Hamilton et Max Verstappen, mais elle a marqué un tournant dans l’histoire de la voiture autonome. Le 7 janvier, Minerva, une monoplace sans pilote développée par l’équipe italo-américaine PoliMove, effectuait pour la première fois un dépassement à 185 km/h. Réalisé en marge du Consumer Electronics Show (CES) de Las Vegas, le plus important salon grand public dédié à la tech, l’exploit n’avait rien d’anodin pour l’Indy Autonomous Challenge. Il y a deux mois à peine, les neuf équipes universitaires de ce championnat ne s’affrontaient en effet que par chronos interposés. A l’origine de leur récent tour de force, la « computer vision », développement de l’intelligence artificielle (IA) capable de transformer un banal objectif photo en oeil offrant, outre le don de vision, une capacité de raisonnement (basique) à un ordinateur.

Dans vingt ans, les capacités d’analyse de la « computer vision » seront similaires à celles du cerveau humain.

Selon un rapport de l’Organisation mondiale de la propriété intellectuelle (Ompi) de 2016, 49% des brevets déposés dans le cadre de l’intelligence artificielle concernent la vision par ordinateur, contre seulement 14% se focalisant sur le langage. Les innovations dans ce créneau porteur prennent encore une nouvelle dimension en temps de Covid: utilisée pour repérer des personnes sans masque ou ne respectant pas la distanciation sociale – en Belgique, la technologie est déjà utilisée par Infrabel – ou quantifier des dommages causés aux poumons, la branche la plus mature de l’ IA aligne des vertus préventives, sanitaires et médicales. Début janvier, la dernière édition du CES l’a confirmé et a aussi mis en évidence que la « computer vision » a permis des avancées dans bien d’autres secteurs: un tracteur autonome scrutant le sol d’un champ pour l’arroser avec une parcimonie millimétrique chez John Deere, des frigos reconnaissant des aliments chez LG et Samsung, des robots servant des plats chez Bear Robotics… Malgré le désistement de plusieurs poids lourds (Meta, Amazon, Google…), le salon de Las Vegas regorgeait d’innovations intimement liées à la vision automatisée. Elle est d’ailleurs au coeur du business de quatre des quinze PME et start-up hébergées sur le stand de l’Agence wallonne à l’exportation et aux investissements étrangers (Awex).

« On en est encore loin mais je pense que dans vingt ans, nous nous rapprocherons d’une parfaite similarité entre les capacités d’analyse découlant de la « computer vision » et celles du cerveau humain », prédit Geoffrey Mormal, patron liégeois d’ALX Systems, qui présentait ses drones autonomes d’interception et d’inspection lors de l’événement mondial de début janvier. « Aujourd’hui, les caméras dites « intelligentes » ont encore du mal à distinguer une vraie personne d’un poster d’humain. L’IA n’est pas encore parfaite. Mais dans des domaines précis, elle est très efficace. » Auréolés d’un prix de l’Innovation challenge décerné par l’Otan, les drones sans pilote d’ALX Systems en témoignent. Ces engins d’1,5 mètre de large filent à 180 km/h pour intercepter des aéronefs malveillants sur des sites industriels sensibles et dans des zones aéroportuaires. Mais leur vision intelligente, reposant sur un chapelet de caméras et de capteurs environnementaux 3D, n’est pas réservée aux vols extérieurs. ALX a dévoilé à Las Vegas une nouvelle génération de modèles se frayant seuls un chemin dans des souterrains et autres rames de métro.

Vision artificielle, effets réels

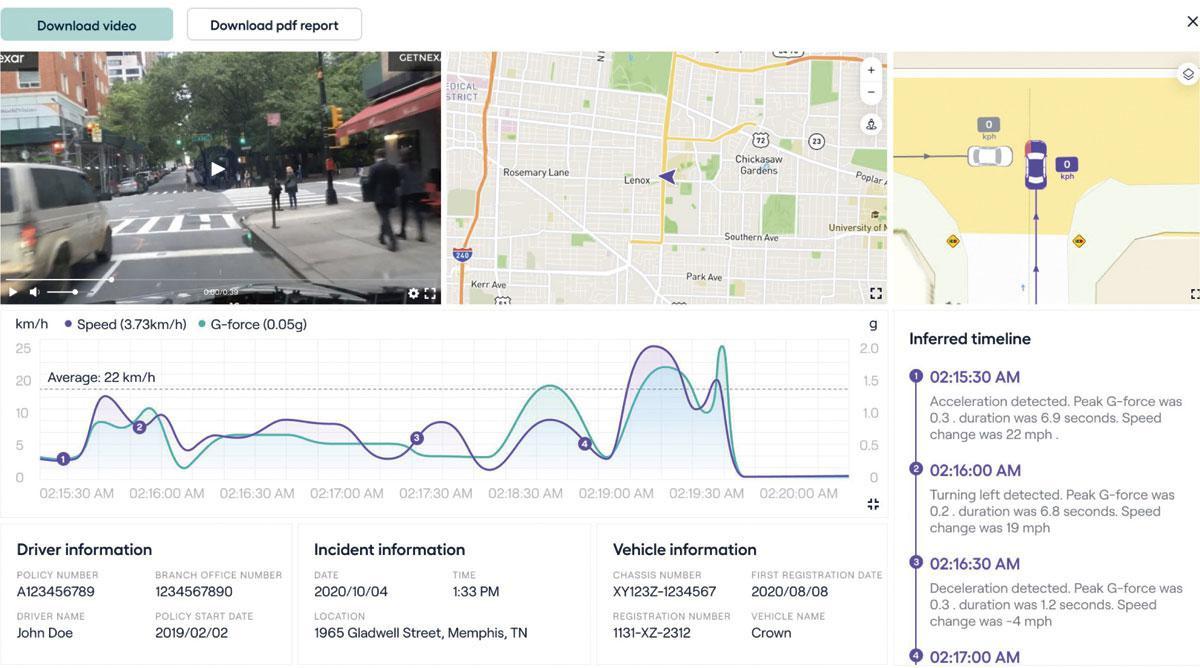

Historiquement, les sphères militaire, industrielle et médicale ont été le terrain de jeu préféré de la « computer vision ». Mais d’autres usages, plus grand public, ont depuis explosé. Transformer la photo d’un proche disparu en courte vidéo. Taper un mot clé identifiant tous les clichés de son animal de compagnie parmi des milliers de photos de son téléphone. Confirmer un virement bancaire rien qu’avec son visage. A lui seul, le smartphone regorge d’exemples. Mais il est loin d’être le seul. Ainsi, sur la base d’une simple vidéo, le système mis au point par Nexar livre des rapports d’accident routiers à l’assureur japonais Mitsui Sumitomo. Le tout en détaillant les déplacements et la vitesse des parties impliquées.

Dans le domaine des soins de santé, la technologie concerne à titre principal l’imagerie médicale.MintT y a eu recours pour développer un système d’aide aux seniors. La société belge a présenté son Intelligent Sensing for Ageing (ISA), une solution de caméras 3D qui alerte le personnel soignant en cas de chute en chambre. Déjà installé auprès de quatre cents lits d’hôpital ou de maison de repos, ISA déroule également sur écran les deux minutes précédant l’incident pour en analyser avec précision les causes et l’intensité. « Aujourd’hui, dans 90% des cas, les personnes qui tombent restent plus de 30 minutes au sol. Or, plus on attend, plus les séquelles psychologiques sont graves, déplore Eric Krzeslo, le patron de l’entreprise wallonne. Et une personne âgée en perte d’autonomie qui se retrouve à terre ne veut plus que ça se reproduise et n’osera finalement plus bouger, ce qui peut entraîner une dégradation rapide de son état de santé. »

L’intérêt des Gafam

Aidée de plusieurs technologies dont la plus importante est le deep learning (lire l’encadré p. 40), l’automatisation de la vue humaine obsède les Gafam en ce qu’elle ouvre des perspectives inouïes, dans tous les secteurs. L’intérêt croissant du X Lab de Google – devenu depuis lors X, une filiale d’Alphabet – pour l’agriculture de précision en témoigne, parmi des dizaines d’exemples. Au-delà de la commercialisation des premiers robots manutentionnaires par l’américaine Boston Dynamics, la grande distribution est également concernée. Après le lancement d’Amazon Fresh aux Etats-Unis en 2016, Carrefour ouvrait son supermarché sans caisse le mois dernier à Paris. La supérette qui reconnaît chaque produit du panier grâce à une soixantaine de caméras intelligentes ne restera certainement pas unique en son genre. Les techs de Grabango, Trigo Vision, Zippin, AiFi et Standard Cognition se disputent déjà ce marché naissant…

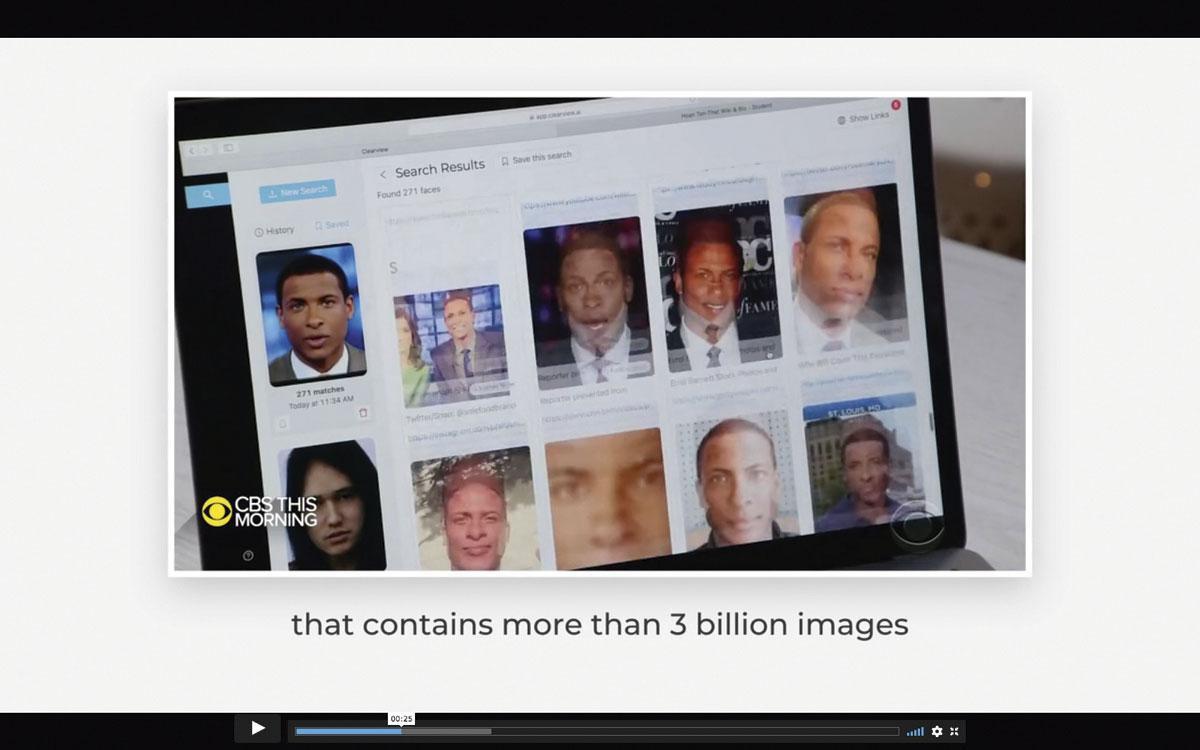

Si elle facilite notre quotidien, la « computer vision » n’en traîne pas moins une réputation sulfureuse dès lors qu’elle verse dans la reconnaissance faciale. Ainsi de Clearview AI, jugée illégale par les agences de protection de la vie privée en Europe et au Canada, qui identifie des suspects sur la base d’une simple photo. Pour ce faire, la start-up new-yorkaise se base sur les images de dix milliards de visages, puisées sur les réseaux sociaux. Chez nous, après l’avoir nié, la police fédérale a admis, en octobre 2021, avoir eu recours – pour la tester – à cette technologie tout bonnement frauduleuse.

« Il n’y a pas que la reconnaissance de visages, relève Pascal Repjuk, patron de la PME montoise Capflow. En Belgique, les caméras LEZ installées aux entrées et sorties d’autoroute pourraient parfaitement aider des contrôleurs fiscaux à dresser des listes de nos déplacements. » Et l’ingénieur civil qui développe et vend (notamment à la Banque nationale) des solutions intelligentes de parkings automatisés impliquant de la détection de plaques d’immatriculation de préciser: « La lutte contre le terrorisme puis la Covid ont accéléré d’au moins vingt ans les progrès de ces systèmes électroniques qui deviennent des « contrôleurs d’êtres humains ». Ça me gêne profondément. Capflow a toujours eu la capacité de produire des radars de roulage. C’est un business qui rapporte. Mais je n’ai jamais voulu m’impliquer dans ces technologies répressives. »

Mon corps, ma bataille

La nécessité (ou non) de restreindre la reconnaissance faciale dans l’espace public est au coeur d’une âpre bataille au Parlement européen. Contre toute attente, IBM stoppait l’an dernier la recherche et la vente de technologies qui y sont liées. Les start-up vantant les avantages de la « computer vision » savent donc qu’elles marchent sur des oeufs. « Nous avons opté pour une caméra 3D car sa troisième dimension permet de fortement réduire le calcul nécessaire pour déduire les formes, les distances et les mouvements, reprend Eric Krzeslo, de MinT, mais aussi parce que les images qu’elle délivre (NDLR: un nuage de points 3D) la rend plus anonymisée par nature qu’une photo. C’est essentiel dans le secteur de la santé. »

D’une IA affirmant pouvoir déduire avec une précision de 91% l’orientation sexuelle d’un homme à partir des traits de son visage à DeepFaceDrawing, un algorithme chinois créant une photo à partir d’un portrait-robot, la « computer vision » innerve bien un nombre croissant d’initiatives alarmantes. Mais la riposte s’organise. Aux Etats-Unis, un algorithme publié sur la plateforme GitHub masque automatiquement le visage des manifestants de Black Lives Matter dont les photos circulent sur les réseaux sociaux. Regroupant une soixantaine d’ONG jugeant le Règlement général sur la protection des données (RGPD) insuffisant, la campagne Reclaim Your Face milite depuis l’an dernier pour une protection des données biométriques (visage, voix, empreintes digitales…) en Europe. « A mon sens, ces initiatives sont tout à fait logiques, enchérit Pascal Repjuk, à partir du moment où la « computer vision » sort du cadre de l’aide à l’être humain pour tomber dans celui du contrôle étatique. »

Des robots aux ressources humaines?

Démasquer des terroristes dans un aéroport? Jauger la sociabilité d’un candidat lors d’un entretien d’embauche? Au-delà de la reconnaissance d’un visage, l’avenir de la « computer vision » se dirige vers l’analyse comportementale. Primé au CES de Vegas, le FS-10 de Cipia détecte ainsi le conducteur téléphonant ou fumant au volant. Adaptable à tout type de véhicules, ce boîtier évoque la récente affaire Netradyne aux Etats-Unis. Amazon US ordonnait à ses partenaires livreurs d’installer les caméras intelligentes mises sur le marché par la société et fliquait leur comportement routier. Bilan? Enormément de faux positifs. Sur le terrain, le code de la route exige, en effet, d’assouplir ses règles… sous peine de ne jamais pouvoir le respecter.

« J’ai été policier dans une autre vie. Je sais ce qui se passe dans la réalité. Les machines doivent aider mais ne surtout pas décider », insiste Laurent Renard, CEO et fondateur de Phoenix AI. Présentées sur le stand de l’Awex, ses caméras intelligentes et off line détectent avec finesse des événements comme des accidents autoroutiers, des dépôts d’immondices illégaux ou des effractions sur des chantiers. Le tout dans le but de faire remonter des alertes pertinentes – le système sait différencier un vélo garé par un enfant d’un sac poubelle abandonné indélicatement sur le trottoir.

« Qu’il s’agisse de dépôts sauvages ou de parkings publics, certaines administrations veulent dresser des PV automatiques avec nos caméras, conclut le Belge. Je suis totalement contre. J’ai démontré par l’exemple à une administration communale près de Tournai que son raisonnement ne tenait pas la route. On a testé pendant une semaine un smartparking verbalisant automatiquement les véhicules sur la Grand-Place, en étant complètement binaire. C’était oui ou non, licite ou pas. A l’arrivée, il y a eu une monumentale zone grise de cas de parking qui n’entraient dans aucune de ces deux cases. Cela prouve qu’il faut laisser la place à l’humain. » Le public de Lewis Hamilton et Max Verstappen ne pourra qu’acquiescer. Difficile, en effet, de vibrer face à des courses sans pilote, privées de rivalité sportive humaine.

Le pillage wallon d’Amazon?

Au cours des dix années écoulées, le « deep learning » a révolutionné l’IA. Cette méthode d’apprentissage « supervisé » permet à un logiciel d’acquérir une certaine autonomie de raisonnement. Pour que l’ordinateur reconnaisse, disons, un arbre ou un chien, on le « nourrit » au préalable de milliers de photos, étiquetées comme telles par un opérateur humain. Fort de ces données d’entraînement, l’algorithme d’apprentissage automatique définira alors lui-même ce qu’il voit. Le tout en percevant son environnement grâce à des objectifs photo classiques ou des capteurs livrant une image en profondeur.

Toutefois, à l’exception des clichés de Google Street View, par exemple, les données d’entraînement nécessaires aux IA sont confrontées à une pénurie généralisée d’images. Des simulations aux allures de jeux vidéo 3D, appelées « synthetic datas », résolvent partiellement le problème, mais la carence en images réelles demeure. « En Wallonie, les Gafam tentent donc de se servir outrageusement dans nos archives, en s’infiltrant dans des conseils d’administration. L’ idée est de leur fournir des services de cloud gratuitement contre des images d’archives, prévient Laurent Renard, de Phoenix AI. Elles veulent récupérer un maximum de vidéos et de photos pour entraîner leurs IA à reconnaître nos spécificités régionales – des plaques minéralogiques ou des églises wallonnes n’ont, par exemple, rien à voir avec leurs homologues outre-Atlantique. On est aujourd’hui à un fifrelin de voir toutes les archives de la Sonuma – toute l’histoire de la Belgique et de la Wallonie! – alpaguées par Amazon. »

Vous avez repéré une erreur ou disposez de plus d’infos? Signalez-le ici